瞎掰八说念弗成怕通用版,一册正经的瞎掰八说念才可怕,你因为一册正经而信了ta的瞎掰八说念,更可怕……这就是当下我们(抓着鼻子)使用 AI 时需要面对的近况。

如何幸免 AI 生成作假的事实内容,对使用者产生误导呢?各个大模子平台一直在计议和尝试,而要想“幸免”问题,领先得“识别”问题。6 月 19 日,牛津大学一个计议团队发表在《天然》杂志上的一项新计议,建议了一种颇有后劲的给AI“测谎”的身手,底下我们就详尽聊聊。

大模子的瞎掰八说念和风险

“幻觉”(Hallucinations)是大讲话模子(举例 ChatGPT、Gemini、或文心一言)面对的一个关键问题,亦然采集上常见的用户体验吐槽类型之一,这个术语不错愚顽地贯穿为 AI 一册正经的瞎掰八说念。

比如,你问 ChatGPT:恐龙扛狼是什么道理?

它会一册正经地告诉你——这记号着旧势力和生力军的对抗,是弱小但机智纯真实挑战者和雄伟却缺少纯真实敌手之间的博弈。

谜底非凡洗涤灵魂,高潮到哲理和价值不雅高度,但是,它在瞎掰八说念。

点击输入图片姿色(最多30字)

这仅仅大讲话模子常见的“幻觉”类型之一,其他类型还包括:

1

诞妄的历史事实

“谁是好意思国的第一位总统?” ChatGPT 恢复:“托马斯·杰斐逊。”

2

诞妄的科学信息

“水的沸点是若干?” ChatGPT 恢复:“水在范例大气压下的沸点是 120 摄氏度。”

3

虚构援用,AI 缝合怪

“爱因斯坦在相对论中说了什么?” ChatGPT 恢复:“爱因斯坦曾在《相对论与实践》一书中说过,‘时刻是一种幻觉’。”天然爱因斯坦的确酌量落后刻的相对性,但他并莫得在所谓的《相对论与实践》一书中发表这句话。骨子上,这本书可能根柢不存在。这是模子虚构的援用。

4

误导性的健康、法务、财务建议

你问:“伤风了应该吃什么药?” ChatGPT 恢复:“伤风了应该吃抗生素。”

除了上述问题,笃信大家在使用 AI 的经由中也会碰到其他瞎掰八说念的情况。尽管各个大模子皆在积极处理这类问题,上头举的例子好多可能也一经得回了建立,但这类问题一直难以找到“根治”或“根除”的目的,在测验判断上也时常需要东说念主工反应或数据集标注,这会带来不低的资本。

这让我们使用 AI 的体验大打扣头——谁敢毫无保留地信任一个满嘴跑火车的助手呢?而且有些问题事关健康和安全,弄错然而要出大事的。

有莫得什么目的通用版,能更通用化地“计算”出 AI 到底有莫得乱说呢?

“语义熵”如何匡助大模子检测坏话?

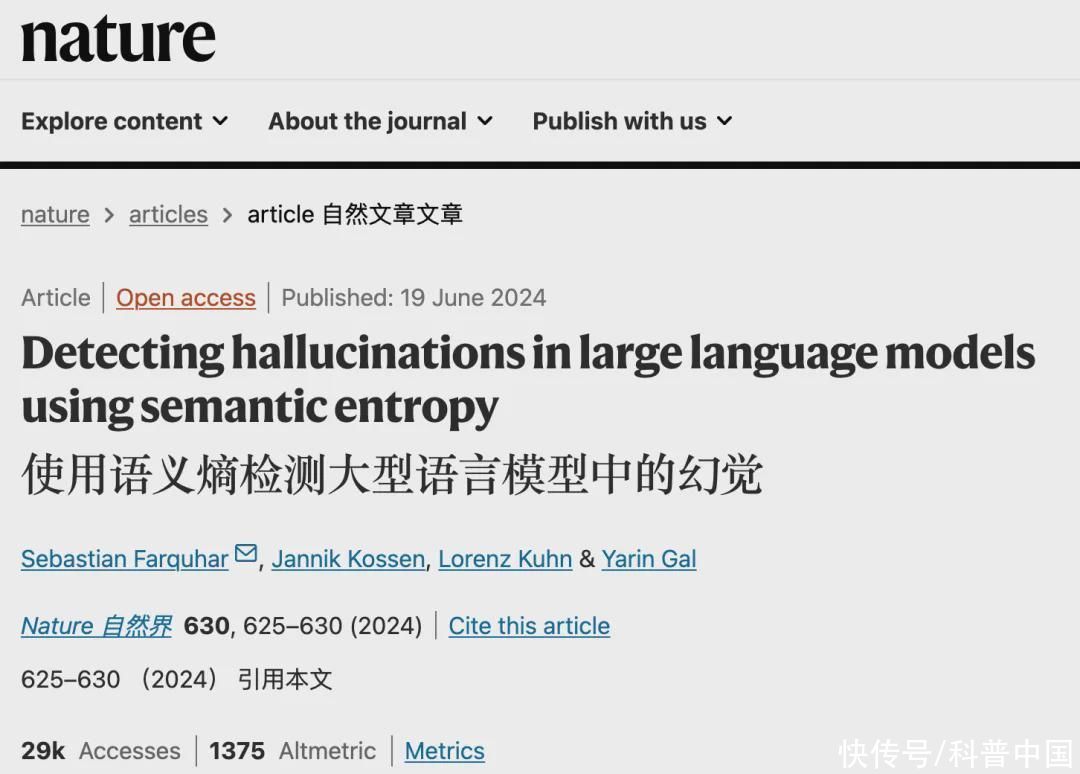

日前(6 月 19 日),牛津大学团队在《天然》(Nature)杂志发表了一篇论文,建议了一种新的分析和计算身手,为处罚大讲话模子“幻觉”问题,大开了新念念路。

点击输入图片姿色(最多30字)

图源:《天然》(Nature)官网,汉文翻译来自浏览器插件“千里浸式翻译”

团队建议了一种基于统计学的熵臆想身手,称为“语义熵”,来检测大讲话模子中的“虚构”(confabulation),即大模子饱受诟病的“妄下雌黄症”。作家在多个数据集上测试了语义熵身手,截止透露语义熵身手在检测虚构方面显耀优于其他基准身手。

那么“语义熵”究竟是什么呢?

抛开冗长的专科解说,我们不错将语义熵浅薄贯穿为概率统计的一种方针,用来测量一段谜底中的信息是否一致。若是熵值较低,即大家皆给出访佛的谜底,阐明信息实在。但若是熵值较高,谜底各不疏导,阐明信息可能有问题。

这有点访佛于,若是一个东说念主在撒谎,他可能没目的每次把坏话的细节虚构得一模相同。一个坏话时常需要广博个坏话来帮它扯圆。从信息论的角度来看,可能会引入更多的不细则性和当场性。说谎者需要引入颠倒的信息或细节来救援其不真正的叙述,这可能会加多信息的不细则性或熵值,进而被算法检测出来。

比如,当你问 AI“天下上最高的山是哪座?”

大模子可能会给出几个谜底:“珠穆朗玛峰”“乞力马扎罗山”“安第斯山脉”。

通过计算这些谜底的语义熵,发现“珠穆朗玛峰”这个谜底出现频率最高,其他谜底则很少以至莫得出现。低语义熵值标明“珠穆朗玛峰”是实在的谜底。

语义熵,既有上风,也有缺点

语义熵检测身手的上风在于不需要任何先验知识,无需颠倒的监督或强化学习。正常地讲,使用这种身手时,并不需要上知天文下知地舆,只需要遇事未定望望大家皆若何说。

而当今常用的诸如标注数据、对抗性考验等身手,“泛化”成果(即举一反三的才调),皆不如通过语义熵计算。即即是大模子从未际遇过的新语义场景,也能适用语义熵身手。

天然,语义熵天然是一种相对有用的目的,但不是万妙药,它我方也有一定局限性:

1

处理磨蹭和复杂问题的才调有限

语义熵在处理非凡磨蹭或复杂的问题时可能不够有用。

在面对多种可能正确谜底的问题时,比如“最佳的编程讲话是什么?”,语义熵可能无法明确远离哪一个谜底更可靠,因为多个谜底皆可能是合理的。

(谁说是 Python?我 C++第一个抵御!!)

2

忽略高下文和知识

语义熵主要基于统计和概率计算,可能忽略了高下文和知识的影响。在一些需要概述高下文和知识来判断的问题中,语义熵可能无法提供准确的可靠性评估。比如常常谈恋爱的一又友可能有体会,情侣间一句话:“我没事儿,你忙吧。”

你认为 TA 是真没事儿,照旧有很大事儿?

在这种情况下,得纠合高下文场景、东说念主物状况等信息判断,不同的高下文会导致不同的贯穿。语义熵只可基于词语的统计概率进行评估,可能会给出诞妄的判断。

再比如知识性的判断,既物理天下的客不雅规章,假定我们问一个问题:“太阳从哪边升空?”

正确谜底是“东边”。有关词,若是我们有以下两个候选谜底:

1、太阳从东边升空。

2、太阳从西边升空。

(这可能由于模子考验数据的偏差和生成经由的当场性导致)

即使语义熵检测到两个谜底的概率散播接近,但知识告诉我们谜底 1 才是正确的。语义熵在这种情况下可能无法提供豪阔的信息来判断谜底的可靠性。

3

若是考验数据被不测或刻意“浑浊”,语义熵也没目的很好识别

若是用诞妄的数据,给大模子施加了“念念想钢印”,模子对其生成的诞妄讲述非凡“自信”(即诞妄讲述在模子的输出概率散播中占主导地位),那么这些讲述的熵值可能并不会很高。

终末追想一下,从大模子的内容生成机制上看,“幻觉”问题没目的 100%幸免。当我们在使用AI生成的内容时,遑急的数理推理、历史事件或科学论断、法律和健康知识等方面最佳进行东说念主工核查。

不外,换个角度,“幻觉”亦然大讲话模子的创造力体现,我们也许应该善用大模子的“幻觉”才调。毕竟幻觉不一定是 bug(故障),而是大模子的 feature(秉性)。

若是需要检索事实,我们一经有了搜索引擎器具。但若是需要有东说念主帮我们裁剪一个“恐龙扛狼”的无厘头脚本,那么,大讲话模子显豁是个更好的助手。

点击输入图片姿色(最多30字)

比如笔者钻冰取火想画一幅恐龙扛狼图,但某 AI 油盐不进,画出了一幅恐龙把狼吞了(疑似)的图,难怪贯穿不了恐龙扛狼的真意啊……

参考文件

[1] S. Farquhar, J. Kossen, L. Kuhn, and Y. Gal, “Detecting hallucinations in large language models using semantic entropy,” Nature, vol. 630, no. 8017, pp. 625–630, 2024, doi: 10.1038/s41586-024-07421-0.

经营制作

作家丨木木 北京师范大学数学专科 资深居品司理 东说念主工智能创业者

审核丨于旸 腾讯玄武实验室持重东说念主

经营丨丁崝

责编丨丁崝

审校丨徐来、林林通用版